رغم إدراك معظم المؤسسات لأهمية وجود حوكمة قوية لنماذج الذكاء الاصطناعي، إلا أن الكثير منها لا يزال يواجه فجوات في هذا الجانب قد تؤخر تبني التقنيات وتزيد من المخاطر. هذا ما كشفته نتائج استطلاع جديد أجرته Anaconda وشمل أكثر من 300 من ممارسي الذكاء الاصطناعي وصانعي القرار، حيث أشار إلى مخاوف تتعلق بأمن الأدوات مفتوحة المصدر، وتفاوت في مراقبة النماذج، إلى جانب تحديات تشغيلية سببها تشتت سلاسل الأدوات المستخدمة في تطوير الذكاء الاصطناعي.

المخاوف الأمنية مستمرة رغم جهود التحقق

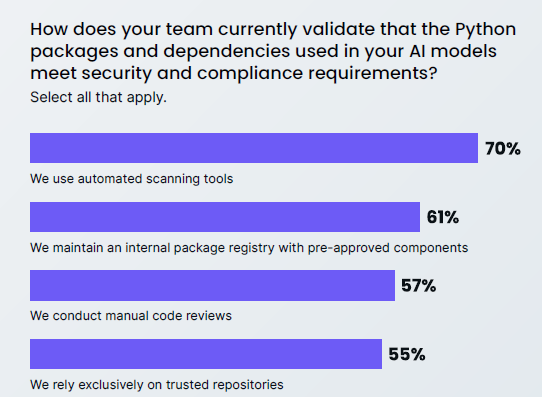

تُعد البرمجيات مفتوحة المصدر ركيزة أساسية في تطوير الذكاء الاصطناعي، لكنها في الوقت نفسه تجلب معها مخاطر سلسلة التوريد التي تحتاج إلى إدارة دقيقة. معظم المشاركين في الاستطلاع أشاروا إلى أنهم يطبقون عمليات للتحقق من حزم Python من حيث الأمان والامتثال، بدءاً من عمليات الفحص الآلي للثغرات، مروراً بالحفاظ على سجلات داخلية للحزم، وصولاً إلى المراجعات اليدوية.

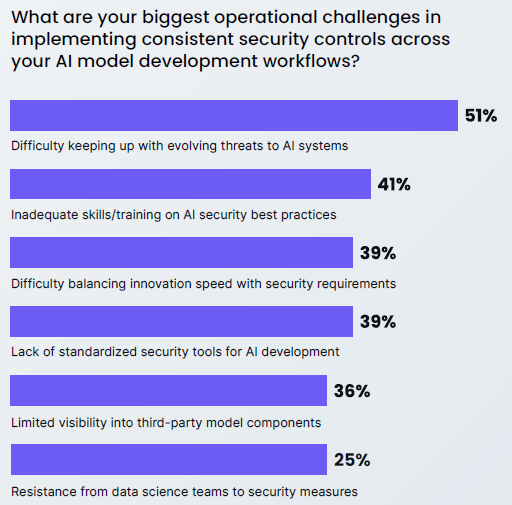

ومع ذلك، تبقى المخاطر الأمنية التحدي الأكثر بروزاً، حيث ذكرها 39٪ من المشاركين كأكبر تهديد. كما أشار نحو ثلثي المؤسسات إلى أنها واجهت تأخيرات في مشاريع الذكاء الاصطناعي بسبب هذه المخاوف، لافتين إلى أن الوقت المستنزف في حل مشكلات الاعتماديات يؤثر سلباً على الإنتاجية. ورغم ثقة معظم الفرق بقدرتها على معالجة الثغرات، فإن تكرار الحوادث يكشف أن الأساليب الحالية لا تكفي لمواكبة حجم وتعقيد المشاريع.

وعن أبرز الأولويات لتحسين الحوكمة، جاءت المطالبة بأدوات أكثر تكاملاً تجمع بين مهام التطوير والأمن في المقدمة. كما أشار المشاركون إلى الحاجة لمزيد من الشفافية حول مكونات النماذج، بالإضافة إلى تعزيز التدريب للفرق.

تفاوت في مراقبة النماذج بين المؤسسات

أظهر الاستطلاع وعيًا واسعًا بأهمية تتبع أصول النماذج، حيث أوضح 83٪ من المؤسسات أنها توثق مصادر النماذج التأسيسية، فيما يحتفظ 81٪ منها بسجلات خاصة بالاعتماديات. لكن هذه التوثيقات ليست دائمًا شاملة، إذ كشف نحو 20٪ من المشاركين أنهم لا يملكون أي توثيق رسمي على الإطلاق.

أما فيما يتعلق بمراقبة الأداء، فالوضع مشابه: 70٪ لديهم آليات لاكتشاف انحراف النماذج أو السلوكيات غير المتوقعة، في حين يفتقر 30٪ لأي مراقبة رسمية عند التشغيل الفعلي. وتشمل الممارسات الشائعة المراقبة الآلية للأداء، أنظمة التنبيه عند ظهور أنماط شاذة، والمراجعات اليدوية الدورية. أما الفرق الأكثر نضج فتتبنى أيضاً تجارب A/B testing وجداول إعادة تدريب منتظمة، لكنها تظل ممارسات غير معممة.

غياب المراقبة المتسقة يترك ثغرات قد تؤثر على الامتثال وجودة الأداء، ومع تعمق الذكاء الاصطناعي في البيئات التشغيلية، ستصبح القدرة على اكتشاف الانحرافات والتعامل معها وظيفة أساسية في الحوكمة.

تشتت سلاسل الأدوات يعرقل التقدم

أفاد 26٪ فقط من المؤسسات أن لديها سلسلة أدوات موحدة بدرجة عالية لتطوير الذكاء الاصطناعي. أما البقية فتتراوح بين بيئات موحدة جزئياً وأخرى شديدة التشتت.

هذا التشتت يعرقل الحوكمة من خلال خلق فجوات في الرؤية، وتكرار الجهود، وفرض ضوابط أمنية غير متسقة. كما يزيد من مخاطر “تكنولوجيا الظل” (Shadow IT) حيث يستخدم الأفراد أدوات غير معتمدة دون إشراف. وعندما تُفرض عمليات الحوكمة على أنظمة متفرقة، تصبح بطيئة ومعقدة، ما يدفع الفرق أحيانًا لتجاوزها.

وأشارت نتائج الاستطلاع أيضاً إلى أن توحيد الأدوات والعمليات يواجه تحدياً ثقافياً، حيث ذكر 25٪ من المشاركين أن مقاومة فرق علم البيانات للإجراءات الأمنية تشكل عائق. الحل يكمن في الاعتماد على منصات متكاملة تُضمّن الحوكمة في سير العمل اليومي، بما يخفف الاحتكاك ويساعد على مواءمة الابتكار مع الرقابة.